Метод «навчання Хеба»

Можна показати, що в цьому випадку лінійна багатошарова мережа не є потужнішою, ніж одношарова мережа; представлені можливості мережі можуть бути поліпшені тільки введенням нелінійності в передавальну функцію нейрона. Кажуть, що мережа, що використовує сигмоїдальну функцію активації і метод навчання Хеба, навчається по сигнальному методу Хеба. У цьому випадку рівняння Хеба модифікується в такий… Читати ще >

Метод «навчання Хеба» (реферат, курсова, диплом, контрольна)

Робота забезпечила основу для більшості алгоритмів навчання, які були розроблені після її виходу. У попередніх цій роботі працях в загальному вигляді визначалося, що навчання в біологічних системах відбувається за допомогою деяких фізичних змін в нейронах, проте були відсутні ідеї про те, яким чином це насправді може мати місце. Грунтуючись на фізіологічних і психологічних дослідження, Хебом було висунуто гіпотезу про те, яким чином може навчатися набір біологічних нейронів. Його теорія припускає тільки локальну взаємодію між нейронами за відсутності глобального вчителя; отже, навчання є некерованим, Незважаючи на те що його робота не включає математичного аналізу, ідеї, викладені в ній, настільки ясні і невимушені, що отримали статус універсальних припущень. Його книга стала класичною і широко вивчається фахівцями, що мають серйозний інтерес у цій області.

Розглянемо алгоритм навчання Хеба. По суті Хеб припустив, що синаптичне з'єднання двох нейронів посилюється, якщо обидва ці нейрона збуджені. Це можна уявити як посилення синапсу відповідно до кореляцією рівнів збуджених нейронів, що з'єднуються даними синапсом. З цієї причини алгоритм навчання Хеба іноді називається кореляційним алгоритмом .

Ідея алгоритму виражається наступним рівністю :

wij (t +1) = wij (t) + NETi NETj ,.

де wij (t) — сила синапсу від нейрона i до нейрона j у момент часу t; NETi — рівень збудження предсинаптичного нейрона; NETj — рівень збудження постсинаптичного нейрона.

Концепція Хеба відповідає на складне питання, яким чином навчання може проводитися без вчителя. У методі Хеба навчання є виключно локальною явищем, що охоплює тільки два нейрона і сполучає їх синапс; не потрібно глобальної системи зворотного зв’язку для розвитку нейронних утворень.

Подальше використання методу Хеба для навчання нейронних мереж призвело до великих успіхів, але поряд з цим показало обмеженість методу; деякі образи просто не можуть використовуватися для навчання цим методом. У результаті з’явилася велика кількість розширень і нововведень, більшість з яких значною мірою базується на роботі Хеба.

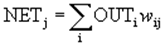

Розглянемо метод сигнального навчання Хеба. Як ми бачили, вихід NET простого штучного нейрона є зваженою сумою його входів. Це може бути виражене таким чином:

навчання вчитель штучний нейрон де NETj — вихід NET нейрона j; OUTi — вихід нейрона i; wij — вага зв’язку нейрона i з нейроном j .

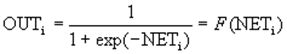

Можна показати, що в цьому випадку лінійна багатошарова мережа не є потужнішою, ніж одношарова мережа; представлені можливості мережі можуть бути поліпшені тільки введенням нелінійності в передавальну функцію нейрона. Кажуть, що мережа, що використовує сигмоїдальну функцію активації і метод навчання Хеба, навчається по сигнальному методу Хеба. У цьому випадку рівняння Хеба модифікується в такий спосіб:

wij (t +1) = wij (t) + OUTi OUTj.

де wij (t) — сила синапсу від нейрона i до нейрона j у момент часу t; OUTi — вихідний рівень пресинаптичного нейрона рівний F (NETi); OUTj — вихідний рівень постсинаптичного нейрона рівний F (NET) .

Розглянемо метод диференціального навчання Хеба. Метод сигнального навчання Хеба передбачає обчислення згортки попередніх змін виходів для визначення зміни ваг. Справжній метод, званий методом диференційного навчання Хеба, використовує наступне рівність :

wij (t +1) = wij (t) + [ OUTi (t) — OUTi (t -1)] [ OUTj (t) — OUTj (t -1)],.

де wij (t) — сила синапсу від нейрона i до нейрона j у момент часу t; OUTi (t) — вихідний рівень пресинаптичного нейрона в момент часу t; OUTj (t) — вихідний рівень постсинаптичного нейрона в момент часу t .